内容来自于机器学习课程

Classification

classification并不是线性回归的

提出了logistic regression

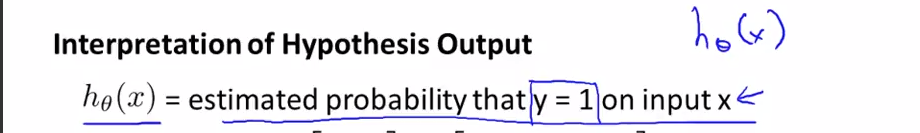

Hypothesis Representation

Sigmoid function = Logistic Function

Decision Boundary

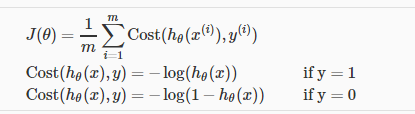

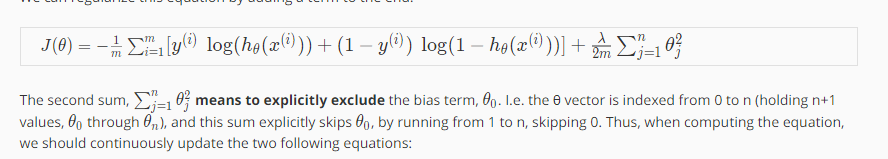

Cost Function

对于Logistic function而言 ,我们不能使用和线性回归一样的cost function,否则会导致局部最优,并且不收敛

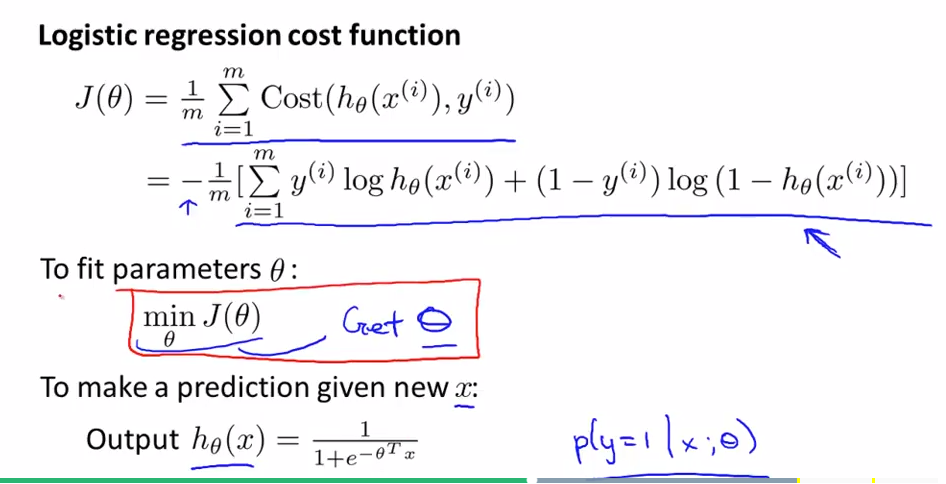

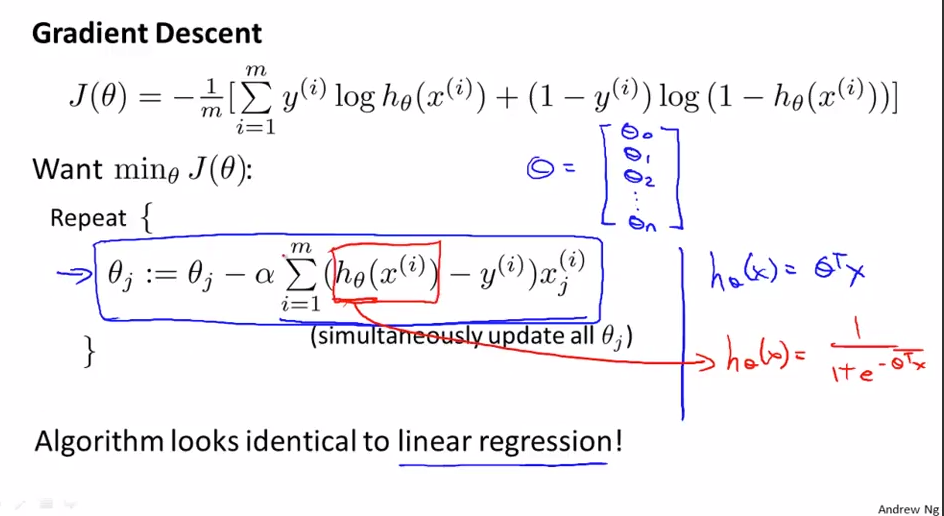

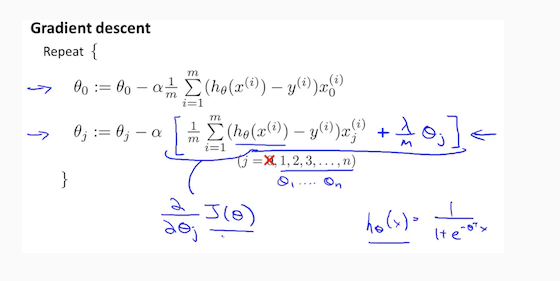

Simplified Cost Function and Gradient Descent

maximum likelihood estimation: 最大似然估计

feature scaling对于逻辑回归也有用处,可以加快梯度下降的速度

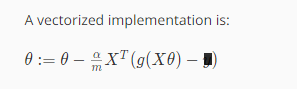

Advanced Optimization

Multi-class clasification: One-vs-all

The problem of overfitting

欠拟合 高偏差 没有很好地拟合训练数据

过度拟合 高方差 变量太多,没有足够的数据来约束这个变量过多的模型,就是过度拟合

过度拟合的没法泛化到新的数据样本。

泛化是指一个假设模型能够应用到新样本的能力

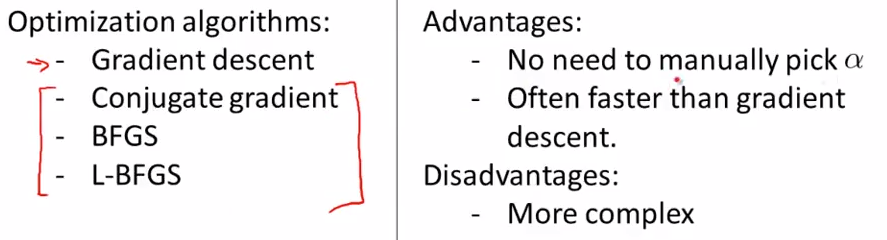

Cost Function

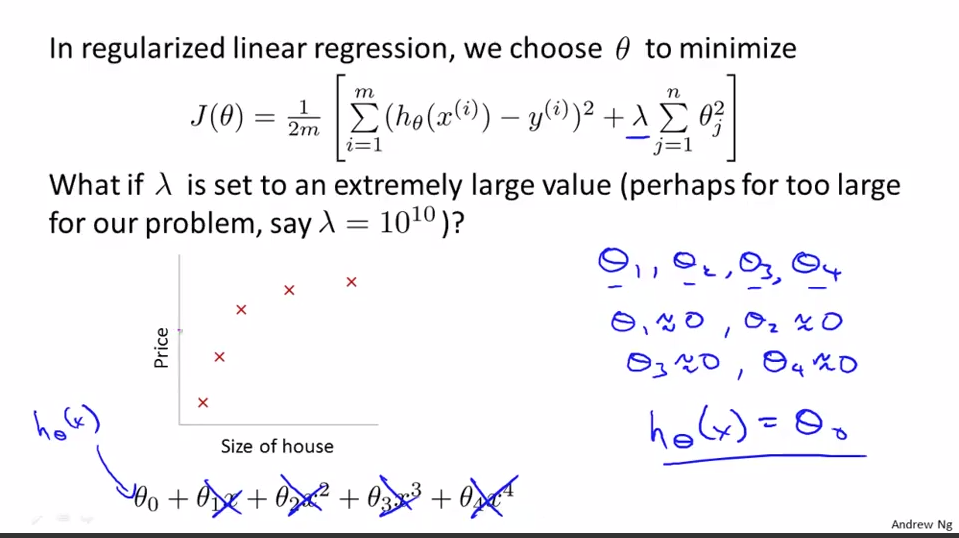

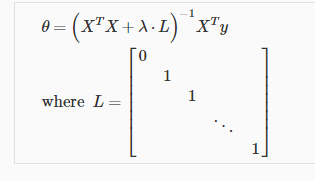

regularized linear regression

regularized logistic regression

DanWang Blog

DanWang Blog